DNS (Domain Name System)

Le DNS est un service informatique qui permet de traduire les noms de domaine lisibles par l'homme en adresses IP lisibles par les machines.

Le DNS, ou Domain Name System, est un service informatique distribué qui associe les noms de domaine Internet avec leurs adresses IP ou d'autres types d'enregistrements.

Les noms de domaine sont les adresses que nous utilisons pour accéder aux sites Web sur Internet. Les adresses IP sont les adresses uniques qui identifient chaque appareil connecté à Internet.

Le DNS permet aux utilisateurs de visiter des sites Web en utilisant des noms de domaine au lieu d'adresses IP. Lorsque vous saisissez un nom de domaine dans votre navigateur Web, le DNS traduit le nom de domaine en adresse IP et renvoie l'adresse IP au navigateur.

Le DNS est un service essentiel pour Internet. Il permet aux utilisateurs de visiter des sites Web facilement et rapidement.

L'e-commerce, ou commerce électronique, fait référence à l'achat et à la vente de biens et de services en ligne. Il s'agit d'une méthode de commerce qui utilise Internet comme plateforme pour effectuer des transactions commerciales. Les sites d'e-commerce permettent aux entreprises de présenter et de vendre leurs produits ou services directement aux consommateurs, offrant souvent des fonctionnalités telles que le panier d'achat, les paiements en ligne, le suivi des commandes, et bien plus encore. L'e-commerce a considérablement changé la façon dont les gens achètent et vendent des produits.

Le webdesign fait référence à la conception visuelle et fonctionnelle d'un site web. Il englobe la disposition des éléments, le choix des couleurs, des typographies, des images, des icônes, des boutons, ainsi que l'organisation des contenus et la navigation. Le webdesign vise à créer une expérience utilisateur agréable, intuitive et esthétique, tout en répondant aux objectifs et à l'identité de la marque ou du site web. Un bon webdesign prend en compte l'ergonomie, la compatibilité multi-appareils et les principes de convivialité pour offrir une interface attrayante et convaincante.

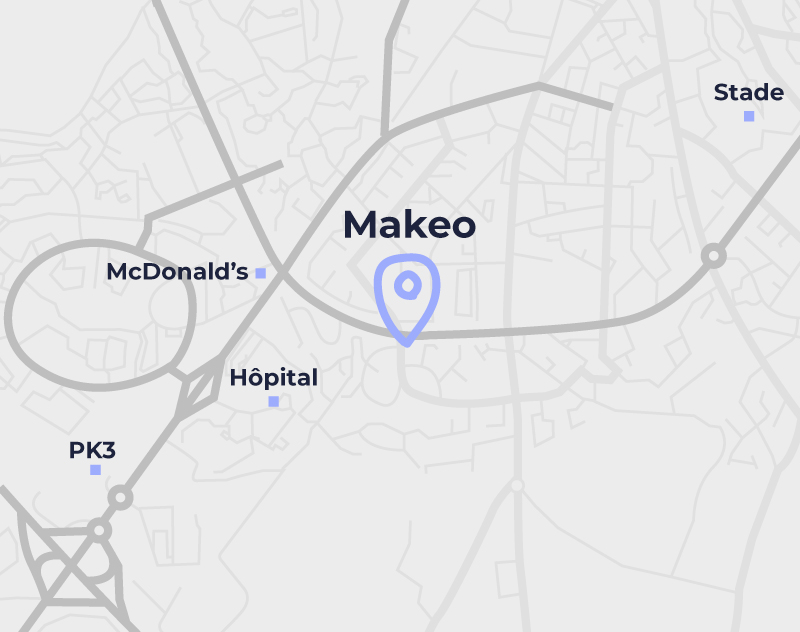

Une maquette, ou mockup, est une représentation visuelle statique ou interactive d'un design ou d'une mise en page. Elle est utilisée pour donner une vision réaliste de l'apparence finale d'un produit, d'une interface ou d'un support de communication, tels qu'un site web, une application, une brochure ou un emballage. Les maquettes sont généralement créées à l'aide d'outils de design graphique et peuvent inclure des éléments visuels tels que des images, des typographies, des couleurs et des effets. Les maquettes permettent de présenter et de valider visuellement un design avant sa mise en production ou sa réalisation finale.